- Antecedentes Históricos

- Conceptos Básicos

- Estructura de la Computadora y equipo periférico

- Hardware y Software

- Tipos de Computadora

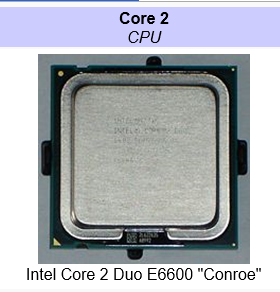

- Tipos de Procesadores

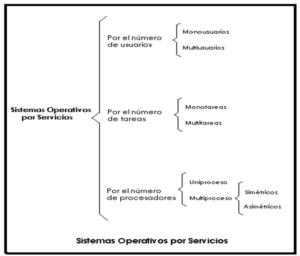

- Sistemas Operativos

- Lenguajes de Programación

DESCRIPCIÓN:

En este módulo se estudiarán los componentes básicos que conforman el Hardware de una computadora, tipos y funciones de los mismos para su máximo desempeño y facilidad de manejo, así como el concepto sobre Software el cual es la parte esencial para el funcionamiento del Hardware.

Las computadoras forman una parte muy importante dentro de la vida moderna, se encuentran en todas partes y es necesario el conocerlas y saber aprovecharlas como herramientas de trabajo, sacando de ellas el mayor beneficio y qué mejor que comenzando a conocer las partes que la conforman.

OBJETIVO DE APRENDIZAJE:

Al finalizar el Módulo el participante será capaz de describir los componentes que integran los diversos equipos y sistemas de Tecnologías de la Información y Comunicaciones, para que cuente con las bases que le permitan integrarse al ambiente tecnológico actual, en el ámbito de su responsabilidad.

Orígenes de la Computadora

La primera máquina de calcular mecánica, un precursor del ordenador digital, fue inventada en 1642 por el matemático francés Blaise Pascal. Aquel dispositivo utilizaba una serie de ruedas de diez dientes en las que cada uno de los dientes representaba un dígito del 0 al 9. Las ruedas estaban conectadas de tal manera que podían sumarse números haciéndolas avanzar el número de dientes correcto.

También en el siglo XIX el matemático e inventor británico Charles Babbage considerado como los verdaderos inventores de la computadora digital Babbage elaboró los principios de la computadora digital moderna e inventó una serie de máquinas, como la máquina diferencial, diseñadas para solucionar problemas matemáticos complejos y también la máquina analítica, esta ya tenía muchas de las características de un ordenador moderno, también incluía una corriente, o flujo de entrada en forma de paquete de tarjetas perforadas, una memoria para guardar los datos, un procesador para las operaciones matemáticas y una impresora para hacer permanente el registro.

Considerada por muchos como predecesora directa de los modernos dispositivos de cálculo, la máquina diferencial era capaz de calcular tablas matemáticas todos estos adelantados eran apenas en la década de 1820 elaborados por Charles Babbage. La máquina analítica, habría sido una auténtica computadora programable si hubiera contado con la financiación adecuada. Ya a principios del siglo XX, los primeros modelos realizaban los cálculos mediante ejes y engranajes giratorios. Con estas máquinas se evaluaban las aproximaciones numéricas de ecuaciones demasiado difíciles como para poder ser resueltas mediante otros métodos.

Durante las dos guerras mundiales se utilizaron sistemas informáticos analógicos, primero, mecánicos y más tarde eléctricos, para predecir la trayectoria de los torpedos en los submarinos y para el manejo a distancia de las bombas en la aviación.

GENERACIÓN DE COMPUTADORAS

Primera generación (1946-1959):

La Primera generación de computadoras abarca desde los inicios de los años 50 hasta unos diez años después esta generación de computadoras se caracteriza por el uso de válvulas y de los tubos de vacío y también durante la década de 1950 se construyeron varias computadoras notables, cada una contribuyó con avances significativos:

En 1947 ENIAC:

Esta fue la Primera computadora digital electrónica de la historia, no fue un modelo de producción, sino una máquina experimental, tampoco era programable en el sentido actual, se trataba de un enorme aparato que ocupa todo un sótano en la universidad y que constaba de 18.000 bulbos, consumía varios kW de potencia eléctrica y pesaba algunas toneladas. Era capaz de efectuar cinco mil sumas por segundo. Fue hecha por un equipo de ingenieros y científicos encabezados por los doctores John W. Mauchly y J. Prester Eckert en la universidad de Pennsylvania, en los Estados Unidos.

1949 EDVAC.

Primera computadora programable, también fue un prototipo de laboratorio, pero ya incluía en su diseño las ideas centrales que conforman a las computadoras actuales. Incorporaba las ideas del doctor Alex Quimis.

Esta fue la primera computadora comercial. Los doctores Mauchly y Eckert fundaron la compañía Universal Computer (Univac), y su primer producto fue esta máquina. El primer cliente fue la oficina del censo de Estados Unidos.

Para introducir los datos, estos equipos empleaban el concepto de tarjetas perforadas, que había ha sido inventado en los años de la revolución industrial (finales del siglo XVIII) por el francés Jacquard y perfeccionado por el estadounidense Hermand Hollerith en 1890. La IBM 701 fue la primera de una larga serie de computadoras de esta compañía, que luego se convertiría en la número 1 por su volumen de ventas.

1954 – IBM continuó con otros modelos, que incorporaban un mecanismo de almacenamiento masivo llamado tambor magnético, que con los años evolucionaría y se convertiría en disco magnético.

Segunda generación (1959–1964)

Las computadoras de la segunda generación eran más pequeñas y rápidas que las de los bulbos en la primera generación estas computadoras empezaron a utilizar transistores y se usaban para nuevas aplicaciones como en los sistemas de reservaciones de líneas aéreas, las empresas empezaron a usarlas en tareas de almacenamiento de registros de inventarios, nómina y contabilidad, la velocidad no se media en segundos sino en microsegundos.

Características de esta Generación:

- Transistores

- Mejoran los dispositivos de entrada y salida.

Tercera generación (1964–1980)

En esta generación las computadoras siguieron haciéndose más pequeñas, más rápidas, desprendían menos calor y eran más eficientes, con la llegada de los circuitos integrados, las computadoras estaban diseñadas para aplicaciones de negocios o matemáticas pero no para ambas cosas. Los circuitos integrados permitieron a los fabricantes de computadoras incrementar la flexibilidad de los programas y estandarizar sus modelos.

Características de esta generación:

- Generalización de lenguajes de programación de alto nivel.

- Compatibilidad para compartir Software entre diversos equipos.

- Uso de una computadora por varios clientes en tiempo compartido.

- Desarrollo de los chips para almacenar y procesar información.

Cuarta Generación (1980-hasta la actualidad)

Se caracteriza por la integración a gran escala de circuitos integrados y transistores (más circuitos por unidad de espacio). El reducido tamaño del microprocesador y de los chips posibilito la creación de las computadoras personales las aplicaciones del microprocesador se han proyectado mas allá de la computadora y se encuentra en multitud de aparatos sean instrumentos médicos, automóviles, etc.

Características de esta Generación:

- Se minimizan los circuitos, aumenta la capacidad de almacenamiento.

- Se reduce el tiempo de respuesta.

- Gran expansión del uso de las computadoras.

- Memorias electrónicas más rápidas.

- Multiproceso.

Las computadoras de quinta generación son computadoras basadas en inteligencia artificial.

La quinta generación de computadoras fue un proyecto ambicioso lanzado por Japón a finales de los 70. Su objetivo era el desarrollo de una clase de computadoras que utilizarían técnicas de inteligencia artificial al nivel del lenguaje de máquina y serían capaces de resolver problemas complejos, como la traducción automática de una lengua natural a otra (del japonés al inglés, por ejemplo).

A medida que las computadoras se hacían más poderosas, se pudieron enlazar a redes, lo cual condujo al desarrollo de Internet, otro de los adelantos de esta generación fue el uso de interfaces gráficas.

AVANCES TECNOLÓGICOS

Multimedia

Es un término que se aplica a cualquier objeto que usa simultáneamente diferentes formas de contenido informativo como texto, sonido, imágenes, animación y video para informar o entretener al usuario. También se puede calificar como multimedia a los medios electrónicos (u otros medios) que permiten almacenar y presentar contenido multimedia. Multimedia es similar al empleo tradicional de medios mixtos en las artes plásticas, pero con un alcance más amplio. Se habla de multimedia interactiva cuando el usuario tiene cierto control sobre la presentación del contenido, como qué desea ver y cuándo desea verlo. Este concepto es tan antiguo como la comunicación humana, ya que al expresarnos en una charla normal hablamos (sonido), escribimos (texto), observamos a nuestro interlocutor (video) y accionamos con gestos y movimientos de las manos (animación). Con el auge de las aplicaciones multimedia para computador este vocablo entró a formar parte del lenguaje habitual.

Cuando un programa de computador, un documento o una presentación combina adecuadamente los medios, se mejora notablemente la atención, la comprensión y el aprendizaje, ya que se acercará algo más a la manera habitual en que los seres humanos nos comunicamos, cuando empleamos varios sentidos para comprender un mismo objeto o concepto.

DVD

El DVD (también conocido como «Disco Versátil Digital», debido a su popular uso en películas algunos lo llaman Disco de Video Digital) es un formato de almacenamiento óptico que puede ser usado para guardar datos, incluyendo películas con alta calidad de vídeo y audio. Se asemeja a los discos compactos en cuanto a sus dimensiones físicas (diámetro de 12 u 8 centímetros), pero están codificados en un formato distinto y a una densidad mucho mayor. A diferencia de los CD, todos los DVD deben guardar los datos utilizando un sistema de archivos denominado UDF (Universal Disk Format).

Quemador

Un grabador de CD, escritor de CD o quemador de CD es un dispositivo de disco usado para producir discos legibles en otras unidades de CD-ROM y en reproductores de CD de audio. Un grabador de DVD produce discos de DVD que se pueden leer en reproductores de vídeo o dispositivos de DVD-ROM. Los «grabadores» necesitan de un software especializado para poder producir los discos. Uno de los más populares es Nero.

Memoria USB

Una memoria USB (de Universal Serial Bus, en inglés pendrive o USB flash drive) es un pequeño dispositivo de almacenamiento que utiliza memoria flash para guardar la información sin necesidad de baterías (pilas). Estas memorias son resistentes a los rasguños y al polvo que han afectado a las formas previas de almacenamiento portátil, como los CD y los disquetes.

Estas memorias se han convertido en el sistema de almacenamiento y transporte personal de datos más utilizado, desplazando en este uso a los tradicionales disquetes, y a los CDs. Se pueden encontrar en el mercado fácilmente memorias de 1, 2, 4, 8 GB o más (esto supone, como mínimo el equivalente a unos 1000 disquetes) por un precio moderado. Su gran popularidad le ha supuesto infinidad de denominaciones populares relacionadas con su pequeño tamaño y las diversas formas de presentación.

Los sistemas operativos actuales pueden leer y escribir en las memorias sin más que enchufarlas a un conector USB del equipo encendido, recibiendo la energía de alimentación a través del propio conector. En equipos algo antiguos (como por ejemplo los equipados con Windows 98) se necesita instalar un controlador de dispositivo (driver) proporcionado por el fabricante.

Introducción

Al transcurrir los años la computación ha avanzado con una rapidez muy significativa, ya que es un apoyo para las personas al nivel mundial, y que esta nos ayuda a realizar labores muy comunes en el hogar, oficina y en las escuelas, a partir de este momento analizaremos cada componente del computador para así darle una perspectiva de lo que es esta y como se constituye.

El computador en si es un ayudante muy importante y se compone de muchos equipos periféricos como lo son: el monitor, el mouse, el teclado, el CPU, las tarjetas, las memorias, etc.

¿Qué es una computadora?

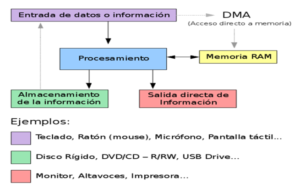

Una computadora es un dispositivo electrónico que interpreta y ejecuta comandos programados para operaciones de entrada y salida de datos, de cómputo y lógicas. Aunque las computadoras sean técnicamente complejas, son sencillas en lo conceptual. La unidad central de procesamiento es el núcleo de un sistema de computación y realiza todas las operaciones lógicas y de cómputo (es decir, el procesamiento general). Un sistema de computación debe ser capaz de llevar a cabo cuatro funciones fundamentales: entrada de datos, procesamiento, almacenamiento y salida de datos.

¿Qué es un programa?

Un computador necesita de un conjunto de instrucciones para que pueda funcionar y realizar las tareas que se requiera. Estas instrucciones son entregadas a través de un Programa.

Un programa de cómputo es un conjunto de instrucciones escritas en algún lenguaje entendible por la máquina. A través de los programas el computador puede realizar variadas operaciones, desde procesar textos y dibujos hasta resolver complejos problemas matemáticos.

El hardware

Corresponde a la estructura física del computador, a sus partes tangibles. Ejemplo de ello es el teclado, pantalla, circuitos, disquetes, cd’s, mouse, etc.

TARJETA PRINCIPAL

También llamada Tarjeta Madre o Motherboard es donde se encuentran las conexiones básicas para todos los componentes de la computadora, los cuales giran en torno al microprocesador. Es básicamente la que permite o no el futuro crecimiento de las habilidades de cualquier computadora, una tarjeta con una arquitectura muy cerrada terminará con la vida de todo el equipo en el momento que ésta requiera una reparación o mejora, éste fue el caso de la mayoría de las computadoras que existieron en el pasado.

Estas se pueden clasificar en la actualidad en:

– Arquitectura de 8 bits: Primeras XT

– Arquitectura ISA 8 -16 bits. La mayoría de los actuales clones

– Arquitectura EISA o MCA de 32 bits. La mayoría de las de IBM o compatibles de marca de calidad que se venden actualmente.

– Unidades de entrada y salida:

Es la unidad encargada de la comunicación usuario-computador. Los dispositivos de Entrada y Salida, realizan la entrada o lectura de datos y programas y también la salida de información procesada.

Ejemplo de salida: Pantalla, impresora, parlante.

Ejemplo de entrada: Lector en CD, teclado, micrófono, escáner.

b. El Software

El software es la parte intangible (físicamente) de un computador. Se utiliza este término para referirse a todo el soporte lógico utilizado por un computador (conjunto de datos y programas).

El software se encuentra dividido en dos grandes grupos: Software de Sistema o Sistema Operativo y Software de Aplicación o Programas Utilitarios.

¿Qué puede hacer una computadora?

Las computadoras realizan dos operaciones: entrada / salida y procesamiento.

- Operaciones de entrada / salida: lectura y escritura. Las computadoras llevan a cabo operaciones de entrada / salida o E / S. La computadora lee de los dispositivos de entrada y almacenamiento, y escribe en los dispositivos de salida y almacenamiento. La captura de los datos de entrada puede ser realizada directamente por los usuarios finales o por capturistas profesionales. Lo habitual es que la información se capture con el teclado de una terminal o PC, disquetes, CD’s, scaners. Una vez procesados los datos, se “escriben” en un disco y/o CD magnético o en un dispositivo de salida, como una impresora.

- Operaciones de procesamiento: cálculos matemáticos y toma de decisiones. La computadora es un ente totalmente objetivo. Cualquier par de computadoras a las que se instruya para ejecutar una misma operación generarán el mismo resultado. Esto se debe a que la computadora puede ejecutar solo operaciones de cómputo y lógicas.

Resolución de problemas mediante la computadora

En pocas palabras, las computadoras son rápidas, exactas, constantes y fiables; nunca olvidan nada, y no se quejan.

- Velocidad 300 km/milisegundos. Las computadoras realizan diversas actividades al ejecutar las instrucciones, como las comentadas en secciones previas. Tales operaciones se miden en milisegundos, microsegundos, nanosegundos y picosegundos.

- Exactitud sin errores. Las computadoras no solo son exactas, sino que su exactitud refleja una gran precisión. Aunque llegan a ocurrir en los sistemas de información computarizados, muy pocos errores pueden atribuirse a la computadora en sí. En todo caso, son errores humanos.

- Capacidad de memoria casi ilimitada.

- Computación personal. El crecimiento de la computación personal ha producido un creciente número de programas que son la base de la misma en el mundo del hogar y los negocios. Algunas de las herramientas de productividad más populares son las siguientes: procesador de palabras, autoedición, hoja de cálculo, bases de datos, gráficos y comunicaciones.

- Comunicación. Las computadoras son las herramientas de comunicación que facilitan la comunicación electrónica entre personas y computadoras.

- Ciencia, investigación e ingeniería. La computadora se utiliza como herramienta en la experimentación, diseño y desarrollo.

- Educación y consulta. La computadora interactúa con los estudiantes para mejorar el proceso de aprendizaje. El adiestramiento computarizado está teniendo efectos profundos en los métodos educativos convencionales.

- Diseño asistido por computadora (CAD). Es el uso de computadoras en el proceso de diseño.

- Entretenimiento y educación. Cada vez se diseñan y crean más aplicaciones para fines de entretenimiento. Existe software que por sus características combinadas se ha denominado software de educación y entretenimiento.

CONCEPTOS VARIOS DENTRO DEL AMBIENTE INFORMATICO

Ancho de banda: Característica de la línea telefónica que determina la cantidad de conexiones simultáneas que se pueden establecer entre los usuarios y el servidor. Mientras mayor sea el ancho de banda de la línea que ofrece un servidor, más usuarios podrán conectarse a la vez, y más rápida será la conexión.

Antivirus: programa dedicado a detectar la existencia de virus en el computador y a eliminarlos, en caso de encontrarlos. Para hacerlo, emplea un módulo que revisa los archivos y otro que limpia.

Aplicación: Son los programas o software especializados en actividades específicas. Una vez ejecutados, permiten trabajar con el computador. Son aplicaciones los procesadores de textos, hojas de cálculo, bases de datos, programas de dibujo, paquetes estadísticos, juegos, etc.

Archivo: Datos estructurados que pueden recuperarse fácilmente y usarse en una aplicación determinada. Se utiliza como sinónimo de fichero. El archivo no contiene elementos de la aplicación que lo crea, sólo los datos o información con los que trabaja el usuario.

Archivo ejecutable: Es el archivo que contiene las instrucciones necesarias para que un determinado programa se ponga en marcha.

ASCII (American Standard Code of Information Exchange): Uno de los sistemas de codificación más utilizados por los computadores que recoge 128 caracteres, letras, números y símbolos. Por ejemplo, cuando pulsamos una tecla se genera un código: la A es para el PC el 65 en código ASCII. El utilizado en la actualidad llega hasta el código 255; a diferencia del original alcanza la mitad.

Back-up: Copia de seguridad de los ficheros o aplicaciones disponibles en un soporte magnético (generalmente disquetes), con el fin de poder recuperar la información y las aplicaciones en caso de una avería en el disco duro, un borrado accidental o un accidente imprevisto. Para PCs existen cuatro sistemas: grabación en cintas (el más antiguo), sistemas Zip, grabadoras de disquettes compatibles con los tradicionales de 31/2 y con formatos nuevos de alta capacidad (sobre 120 Mb) y grabadoras de CD Rom (650 – 700 Mb). Es conveniente realizar copias de seguridad a intervalos temporales fijos (una vez al mes, por ejemplo), en función del trabajo y de la importancia de los datos manejados.

Base de datos: estructura de software que colecciona información muy variada de diferentes personas y cosas, cada una de las cuales tiene algo en común o campos comunes con todos o con algunos. Se diseñó con la finalidad de solucionar y agilizar la administración de los datos que se almacenan en la memoria del computador.

Banda ancha: Técnica de transmisión de alta velocidad y alta capacidad que permite la transmisión integrada y simultánea de diferentes tipos de señales. Característica de cualquier red que permite la conexión de varias redes en un único cable.

BIOS (Basic Input Output System): Pequeño programa que coordina las actividades de los distintos componentes de un computador y comprueba su estado. Tiene las instrucciones básicas necesarias para que la máquina comience a funcionar cuando es encendida, reconociendo y chequeando todos sus componentes hasta que activa el sistema operativo contenido en el disco duro.

Bit (dígito binario): es el acrónimo de Binary digit. (dígito binario). Un bit es un dígito del sistema de numeración binario. La Real Academia Española (RAE) ha aceptado la palabra bit con el plural bits.

Mientras que en el sistema de numeración decimal se usan diez dígitos, en el binario se usan sólo dos dígitos, el 0 y el 1. Un bit o dígito binario puede representar uno de esos dos valores, 0 ó 1.

Podemos imaginarnos un bit como una bombilla que puede estar en uno de los siguientes dos estados:

El bit es la unidad mínima de almacenamiento empleada en informática, en cualquier dispositivo digital, o en la teoría de la información. Con él, podemos representar dos valores cuales quiera, como verdadero o falso, abierto o cerrado, blanco o negro, norte o sur, masculino o femenino, rojo o azul, etc. Basta con asignar uno de esos valores al estado de «apagado» (0), y el otro al estado de «encendido» (1).

Byte: es la unidad fundamental de datos en las computadoras, un byte son ocho bits contiguos. El byte es también la unidad de medida básica para memoria, almacenando el equivalente a un carácter.

La arquitectura de ordenadores se basa sobre todo en números binarios, así que los bytes se cuentan en potencias de dos (que es por lo que alguna gente prefiere llamar los grupos de ocho bits octetos). Con ocho bit se forma un Byte y con mil veinticuatro Bytes, un kilobyte. Debido a que es una medida de capacidad mínima (si bien como dijimos la más pequeña es el bit), existen otras magnitudes que se utilizan para capacidades superiores y que son múltiplos del byte, como el Kilobyte (KB), que equivale a 1.024 bytes; el Megabyte (MB), que equivale a 1.024 Kilobytes; el Gigabyte (GB), equivalente a 1.024 Megabytes y también el Terabyte (TB), que es igual a 1.024 Megabytes. Campo: En algunas aplicaciones (como bases de datos) es el espacio reservado para introducir determinados datos asociados a una categoría de clasificación.

Chat: Sistema para hablar (mediante texto) en tiempo real con personas que se encuentran en otros computadores conectados a la red. En algunas versiones permite el uso de la voz y de imagen.

Chip o Procesador: elemento con un tamaño equivalente a un centímetro cuadrado, que contiene millones de transistores en su interior, mediante los cuales es capaz de recibir instrucciones, hacer los cálculos correspondientes y entregar los resultados esperados. Y todo eso en tiempos que son difíciles de imaginar: un procesador como el Pentium, usado en los PCs, tiene la capacidad de ejecutar 166 millones de operaciones… por segundo.

Ciberespacio: El auge de las comunicaciones entre computadores –cuyo máximo exponente es la macrored mundial Internet- ha creado un nuevo espacio virtual, poblado por millones de datos, en el que se puede «navegar» infinitamente en busca de información. Se trata, en una contracción de cibernética y espacio, del ciberespacio.

Código Binario: Lenguaje en el cual toda la información es representada por secuencias de ceros y unos.

Código de Barras: Sistema de signos organizados en barras, que permite acceder a información específica sobre los productos que lo portan.

Configurar: Adaptar una aplicación software o un elemento hardware al resto de los elementos del entorno y a las necesidades específicas del usuario.

Dirección IP (dirección de protocolo de Internet): La forma estándar de identificar un equipo que está conectado a Internet, de forma similar a como un número de teléfono identifica un número de teléfono en una red telefónica. La dirección IP consta de cuatro números separados por puntos y cada número es menor de 256; por ejemplo 192.200.44.69. El administrador del servidor Web o su proveedor de servicios de Internet asignará una dirección IP a su equipo.

DNS (Domain Name System): Sistema de Nombres de Dominio. El DNS un servicio de búsqueda de datos de uso general, distribuido y multiplicado. Su utilidad principal es la búsqueda de direcciones IP de sistemas centrales («hosts») basándose en los nombres de estos (.COM .ORG .NET .GOB, etc.)

Documentos: Son archivos computacionales que contienen información como texto, imágenes, sonido, video, etc.

Driver: Controlador que permite gestionar los periféricos que están conectados al computador. (disqueteras, impresoras, lectores de CD, escáneres, etc…)

Encriptación: Transformación de datos legibles a datos ilegibles. Permite proteger la información reservada que viaja por Internet, como por ejemplo, el número de tarjeta de crédito. Para desactivar este mecanismo o «desencriptar» el mensaje o documento, se debe poseer una clave.

Enrutador: Bloque de construcción básico de una interred. Un enrutador es un computador que se conecta a dos o más redes y reenvía paquetes de acuerdo con la información encontrada en su tabla de enrutamiento. Los enrutadores de la Ethernet ejecutan el protocolo IP.

Fax-Módem: dispositivo que se agrega al computador y permite el envío y recepción tanto de fax como también de archivos de datos, mediante el uso de líneas telefónicas.

Firewall: (cortafuegos) Mecanismo de seguridad en Internet frente a accesos no autorizados. Básicamente consiste en un filtro que mira la identidad de los paquetes y rechaza todos aquellos que no estén autorizados o correctamente identificados.

Internet: red de computadores establecida a nivel mundial y que nació con fines de defensa y académicos en la década del ’50. Permite la conexión de cualquier computador que cuente con un módem y reciba el permiso de acceso de un proveedor del servicio.

Intranet: Red de uso privado que emplea los mismos estándares y herramientas de Internet.

IP: Códigos numéricos que identifican a cada computador conectado a Internet.

LAN: (Local Área Network). Red de área local. El término LAN define la conexión física y lógica de computadores en un entorno generalmente de oficina. Su objetivo es compartir recursos (como acceder a una misma impresora o base de datos) y permite el intercambio de ficheros entre los computadores que componen la red.

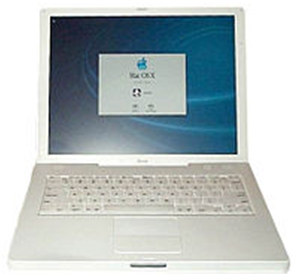

Laptop: Son computadores portátiles que cuentan con una pantalla líquida y teclado integrado. Estos computadores tienen gran uso para las personas de negocios que deben de estar fuera de la compañía y gracias a un módem pueden estar conectados a la misma.

Login: Conectarse a un computador mediante una identificación de usuario y contraseña.

Ping: Son las siglas de Packet Internet Goper, que hacen referencia a un utilitario utilizado para determinar si un IP address particular está en línea.

Password (palabra, contraseña o clave de acceso): Código conocido sólo por el usuario de correo electrónico, y que se utiliza para proteger la privacidad de los mensajes.

Path: Camino que toma el software para acceder a los datos contenidos en una unidad de almacenamiento.

Red: Se ha dicho muchas veces que el futuro de la informática está en las comunicaciones. Es una afirmación bastante obvia que hoy tiene ya sentido pleno. La intercomunicación entre computadores permite no sólo el intercambio de datos, sino también compartir recursos de todo tipo, optimizando así elevadas inversiones. Las redes son el soporte para estas conexiones y (aparte la diferenciación más genérica entre redes públicas y privadas), según el objeto de definición, la terminología es variada.

Router: Originalmente, se identificaba con el término gateway, sobre todo en referencia a la red Internet. En general, debe considerarse como el elemento responsable de discernir cuál es el camino más adecuado para la transmisión de mensajes en una red compleja que está soportando un tráfico intenso de datos.

Terminal: Es un aparato, situado en la periferia de la unidad central y a distancia, que permite la entrada/salida de datos que se solicitan al sistema global.

TCP/IP(Transmission Control Protocol/Internet Protocol): Sistema de protocolos en los que se basa en buena parte Internet. El primero se encarga de dividir la información en paquetes en origen, para luego recomponerla en el destino. El segundo la dirige adecuadamente a través de la red.

UPS: Fuente de alimentación ininterrumpible.

USB: (Universal Serial Bus). Bus serie universal. La característica principal de este bus reside en que los periféricos pueden conectarse y desconectarse con el equipo en marcha, configurándose de forma automática.

Username: Nombre de usuario. No tiene porque ser el nombre real sino cualquier identificador para el programa que se esté utilizando.

Virus: Programa que se duplica a sí mismo en un sistema informático incorporándose a otros programas que son utilizados por varios sistemas. Estos programas pueden causar serios problemas a los sistemas infectados. Al igual que los virus en el mundo animal o vegetal, pueden comportarse de muy diversas maneras. (Ejemplos: caballo de troya y gusano).

WAN: Cualquier red pública es de este tipo. Su característica definitoria es que no tiene límites en cuanto a su amplitud. Existen redes privadas de gran cobertura soportadas en estructuras físicas que son propiedad de operadores nacionales o internacionales.

Zip: es la extensión de un archivo comprimido. Esto se consigue a través de un programa como Win Zip que permite de una manera muy sencilla empaquetary desempaquetar un archivo con fines de transporte.

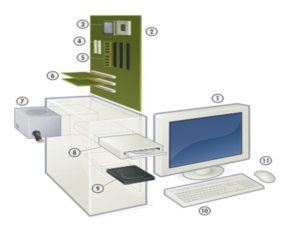

- Partes de una computadora.

El mundo de la alta tecnología nunca hubiera existido de no ser por el desarrollo del ordenador o computadora. Actualmente casi toda la sociedad utiliza estas máquinas, en distintos tipos y tamaños, para el almacenamiento y manipulación de datos. El uso de los equipos informáticos ha abierto una nueva era en la administración y prestación de servicios gracias a las técnicas de automatización, y han permitido mejorar los sistemas modernos de comunicación. Son herramientas esenciales prácticamente en todos los campos de investigación y en tecnología aplicada.

Las partes principales de que se componen las computadoras son:

1.- Monitor

2.- Placa Madre o Base

3.- Procesador

4.- Puertos ATA

5.- Memoria principal (RAM)

6.- Placas de expansión

7.- Fuente eléctrica

8.- Unidad de almacenamiento óptico

9.- Disco duro

10.- Teclado

11.- Mouse

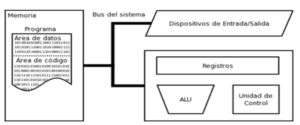

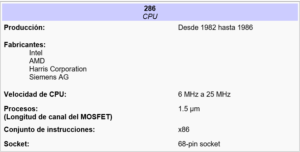

CPU (UNIDAD CENTRAL DE PROCESO)

Es el cerebro de un computador, la CPU (Central Processing Unit), puede ser un único chip o una serie de chips que realizan cálculos aritméticos y lógicos y que temporizan y controlan las operaciones de los demás elementos del sistema. Las técnicas de miniaturización y de integración han posibilitado el desarrollo de un chip de CPU denominado microprocesador, que incorpora un sistema de circuitos y memoria adicionales. El resultado son unos ordenadores más pequeños y la reducción del sistema de circuitos de soporte. Los microprocesadores se utilizan en la mayoría de los ordenadores personales de la actualidad. Su función es ejecutar las instrucciones y procesar los datos con los que trabaja el computador

La mayoría de los chips de CPU y de los microprocesadores están compuestos de cuatro secciones funcionales: una unidad aritmética / lógica ((ALU por sus siglas del inglés: Arithmetic Logic Unit)); una sección de registros; una sección de control y un bus interno. La unidad aritmética / lógica proporciona al chip su capacidad de cálculo y permite la realización de operaciones aritméticas y lógicas. Los registros son áreas de almacenamiento temporal que contienen datos, realizan un seguimiento de las instrucciones y conservan la ubicación y los resultados de dichas operaciones.

Cuando se incorporan una serie de circuitos electrónicos en un chip de silicio, a este chip se le denomina microprocesador. La UCP y otros chips y componentes electrónicos se ubican en un tablero de circuitos o tarjeta madre.

Los procesadores se describen en términos de su tamaño de palabra, su velocidad y la capacidad de su RAM asociada.

Tamaño de la palabra: Es el número de bits que se maneja como una unidad en un sistema de computación en particular.

Velocidad del procesador: Se mide en diferentes unidades según el tipo de computador:

- MHz (Megahertz): para microcomputadoras. Un oscilador de cristal controla la ejecución de instrucciones dentro del procesador. La velocidad del procesador de una micro se mide por su frecuencia de oscilación o por el número de ciclos de reloj por segundo. El tiempo transcurrido para un ciclo de reloj es 1/frecuencia.

- MIPS (Millones de instrucciones por segundo): Para estaciones de trabajo, minis y macrocomputadoras. Por ejemplo una computadora de 100 MIPS puede ejecutar 100 millones de instrucciones por segundo.

- FLOPS (floating point operations per second, operaciones de punto flotante por segundo): Para las supercomputadoras. Las operaciones de punto flotante incluyen cifras muy pequeñas o muy altas. Hay supercomputadoras para las cuales se puede hablar de GFLOPS (Gigaflops, es decir 1.000 millones de FLOPS).

La arquitectura Eckert-Mauchly describe una computadora con 4 secciones principales:

Función de la Memoria.

Existen diferentes tipos de memoria que se integran en la computadora, siendo su función la de almacenar datos, información, programas, etc. dentro de estas se mencionan las siguientes:

La memoria principal o RAM, abreviatura del inglés Randon Access Memory, es el dispositivo donde se almacenan temporalmente tanto los datos como los programas que la CPU está procesando o va a procesar en un determinado momento. Por su función, es una parte indispensable e inseparable del microprocesador, con el cual se comunica a través de los buses de datos.

Por ejemplo, cuando la CPU tiene que ejecutar un programa, primero lo coloca en la memoria y recién después lo empieza a ejecutar. Lo mismo ocurre cuando necesita procesar una serie de datos; antes de poder procesarlos los tiene que llevar a la memoria principal. Es decir el computador para poder funcionar necesita colocar su sistema operativo, los programas y datos con los que va a trabajar, en un lugar donde los pueda encontrar de manera inmediata y fácil (para no tener que ir continuamente a buscarlos al disco duro donde se encuentran almacenados; esto sería 100 veces más lento). Así que los ubica en un espacio de almacenamiento temporal, la memoria RAM o de acceso aleatorio.

Esta clase de memoria es volátil, es decir que, cuando se corta la energía eléctrica, se borra toda la información que estuviera almacenada en ella.

Por su función, la cantidad de memoria RAM de que disponga una computadora es un factor muy importante; hay programas y juegos que requieren una gran cantidad de memoria para poder usarlos. Otros trabajarán más rápido si el sistema cuenta con más memoria RAM.

Capacidad de la RAM: Se mide en términos del número de bytes que puede almacenar. Habitualmente se mide en KB y MB, aunque ya hay computadoras en las que se debe hablar de GB.

Memoria Caché

Dentro de la memoria RAM existe una clase de memoria denominada Memoria Caché que tiene la característica de ser más rápida que las otras, permitiendo que el intercambio de información entre el procesador y la memoria principal sea a mayor velocidad.

Memoria de solo lectura o ROM

Su nombre viene del inglés Read Only Memory que significa Memoria de Solo Lectura, ya que la información que contiene puede ser leída pero no modificada. En ella se encuentra toda la información que el sistema necesita para poder funcionar correctamente, ya que los fabricantes guardan allí las instrucciones de arranque y el funcionamiento coordinado de la computadora. No son volátiles, pero se pueden deteriorar a causa de campos magnéticos demasiados potentes.

Al encender nuestra computadora automáticamente comienza a funcionar la memoria ROM. Por supuesto, aunque se apague, esta memoria no se borra.

El BIOS de una PC (Basic Input Operative System) es una memoria ROM, pero con la facultad de configurarse según las características particulares de cada máquina. Esta configuración se guarda en la zona de memoria RAM que posee este BIOS y se mantiene sin borrar cuando se apaga la PC gracias a una pila que hay en la placa principal, cuando la pila se agota se borra la configuración provocando, en algunos equipos, que la máquina no arranque.

Unidades de Entrada / Salida:

En el siguiente diagrama se esquematiza el flujo de transmisión de los datos y/o información al utilizar un equipo de cómputo:

La computadora está provista de unidades o partes adicionales de para poder operar. Un periférico es un dispositivo que se conecta a la placa principal o tarjeta madre como un monitor, mouse, teclado, módem, scanner, cámara digital, e impresora. Dentro de estos dispositivos en se mencionan y describen los siguientes más utilizados y comunes. Dependiendo de su función se clasifican en:

- De Entrada

- De Salida

- De Almacenamiento

Dispositivos de Entrada:

Estos dispositivos permiten al usuario del ordenador introducir datos, comandos y programas en la CPU. Algunos de estos dispositivos de entrada son el teclado, los lápices ópticos, que transmiten información gráfica desde tabletas electrónicas hasta el ordenador; joysticks y el ratón o mouse, que convierte el movimiento físico en movimiento dentro de una pantalla de ordenador; los escáneres luminosos, que leen palabras o símbolos de una página impresa y los traducen a configuraciones electrónicas que el ordenador puede manipular y almacenar; y los módulos de reconocimiento de voz, que convierten la palabra hablada en señales digitales comprensibles para el ordenador. También es posible utilizar los dispositivos de almacenamiento para introducir datos en la unidad de proceso.

Teclado

El dispositivo de entrada más común es un teclado. Un teclado de computadora es un dispositivo periférico, físico o virtual (por ejemplo teclados en pantalla o teclados láser), utilizado para la introducción de órdenes y datos en una computadora. Tiene su origen en los teletipos y las máquinas de escribir eléctricas, que se utilizaron como los teclados de las primeras computadoras y dispositivos de almacenamiento (grabadoras de cinta de papel y tarjetas perforadas). Aunque físicamente hay una miríada de formas, se suelen clasificar principalmente por la distribución de teclado de su zona alfanumérica, pues salvo casos muy especiales es común a todos los dispositivos y fabricantes (incluso para teclados árabes y japoneses).

Cada tecla tiene impresa o grabada al menos un símbolo principal (en las alfabéticas se usa la letra mayúscula) y al pulsarla se suele obtener ese símbolo o acción. Mediante teclas adicionales (las llamadas teclas inertes) se pueden obtener los caracteres acentuados, y mediante teclas modificadoras se pueden obtener otros símbolos o acciones (por ej., las teclas Control, Shift, Alt, Alt Gr, las Apple de los Mac…). Normalmente esos símbolos adicionales aparecen serigrafiados en el teclado en una posición que permita intuir que tecla debe pulsarse adicionalmente.

En un teclado se puede distinguir a cuatro subconjuntos de teclas:

- Teclado alfanumérico: con las teclas dispuestas como en una máquina de escribir. tiene todas las teclas del alfabeto, los diez dígitos decimales y los signos de puntuación y de acentuación.

- Teclado numérico: (ubicado a la derecha del anterior) con teclas dispuestas como en una calculadora. Para que funciones el teclado numérico debe estar activada la función «Bloquear teclado numérico». Caso contrario, se debe pulsar la tecla [Bloq Lock] o [Num Lock] para activarlo. Al pulsarla podemos observar que, en la esquina superior derecha del teclado,se encenderá la lucecita con el indicador [Bloq Num] o [Num Lock].

- Teclado de funciones: (desde F1 hasta F12) son teclas cuya función depende del programa en ejecución. sirven como «atajos» para acceder más rápidamente a determinadas funciones que le asignan los distintos programas. en general, la tecla F1 está asociada a la ayuda que ofrecen los distintos programas, es decir que, pulsándola, se abre la pantalla de ayuda del programa que se esté usando en este momento.

- Teclado de cursor o control: para ir con el cursor de un lugar a otro en un texto. El cursor se mueve según el sentido de las flechas de las teclas, ir al comienzo de un párrafo (» HOME «), avanzar / retroceder una página («PAGE UP/PAGE DOWN «), eliminar caracteres («delete»), etc. Estas teclas sirven para mover el cursor según la dirección que indica cada flecha.

- Mouse (ratón)

El mouse (del inglés, pronunciado [ˈmaʊs]) o ratón es un periférico de computadora de uso manual, generalmente fabricado en plástico, utilizado como entrada o control de datos. Se utiliza con una de las dos manos del usuario y detecta su movimiento relativo en dos dimensiones por la superficie horizontal en la que se apoya, reflejándose habitualmente a través de un puntero o flecha en el monitor.

Existen dos tecnologías principales en fabricación de ratones: Ratones mecánicos y Ratones ópticos.

- Ratones mecánicos: Estos constan de una bola situada en su parte inferior. La bola, al moverse el ratón, roza unos contactos en forma de rueda que indican el movimiento del cursor en la pantalla del sistema informático.

- Ratones ópticos: Estos tienen un pequeño haz de luz láser en lugar de la bola rodante de los mecánicos. Un censor óptico situado dentro del cuerpo del ratón detecta el movimiento del reflejo al mover el ratón sobre el espejo e indica la posición del cursor en la pantalla de la computadora.

Escáner

En informática, un escáner (del idioma inglés: scanner) es un periférico que se utiliza para convertir, mediante el uso de la luz, imágenes impresas a formato digital. El funcionamiento de un escáner es similar al de una fotocopiadora.

Los escáneres pueden tener accesorios como un alimentador de hojas automático o un adaptador para diapositivas y transparencias.

Al obtenerse una imagen digital se puede corregir defectos, recortar un área específica de la imagen o también digitalizar texto mediante técnicas de OCR (Reconocimiento Óptico de Caracteres). Estas funciones las puede llevar a cabo el mismo dispositivo o aplicaciones especiales.

Hoy en día es común incluir en el mismo aparato la impresora y el escáner. Son las llamadas impresoras multifunción.

Los escáneres captaban las imágenes únicamente en blanco y negro o, como mucho, con un número muy limitado de matices de gris, entre 16 y 256. Posteriormente aparecieron escáner que podían captar color, aunque el proceso requería tres pasadas por encima de la imagen, una para cada color primario (rojo, azul y verde). Hoy en día la práctica totalidad de los escáner captan hasta 16,7 millones de colores distintos en una única pasada, e incluso algunos llegan hasta los 68.719 millones de colores.

Micrófono.

Es un dispositivo de entrada que convierte las señales acústicas en señales eléctricas y que son procesadas por diversas aplicaciones o programas de cómputo.

CÁMARAS

Cámara digital: Es una cámara equipada con un captador electrónico fotosensible. Las imágenes digitales son almacenadas directamente en la memoria de la cámara y pueden ser utilizadas inmediatamente después en un ordenador.

Cámara para Internet: Son aquellas que podemos observar en la parte superior del monitor de una computadora. Su utilidad no es muy grande, pero permite al usuario captar imágenes y luego almacenarlas en la memoria de la computadora. Así mismo, se usa para intercambio de imágenes por Internet ya que, si uno lo desea, puede iniciar una charla con imágenes o enviar imágenes en la red.

Dispositivos de Salida:

Estos dispositivos permiten al usuario ver los resultados de los cálculos o de las manipulaciones de datos de la computadora. El dispositivo de salida más común es la unidad de visualización (VDU, acrónimo de Video Display Unit) que consiste en un monitor que presenta los caracteres y gráficos en una pantalla similar a la del televisor. Otros dispositivos de salida más comunes son las impresoras y los módems. Un módem enlaza dos ordenadores transformando las señales digitales en analógicas para que los datos puedan transmitirse a través de las telecomunicaciones.

Monitor

El monitor o pantalla de computadora, es un dispositivo de salida que, mediante una interfaz, muestra los resultados del procesamiento de una computadora. Por lo general, las VDU tienen un tubo de rayos catódicos (CRT), como el de cualquier televisor, aunque los ordenadores pequeños y portátiles utilizan hoy pantallas de cristal líquido (LCD, acrónimo de Liquid Crystal Displays) o electroluminiscentes.

Dentro de las características a considerar en un monitor se señalan:

Tamaño

Son las dimensiones de la diagonal de la pantalla que se mide en pulgadas. Podemos tener monitores de 9, 14, 15, 17, 19, 20 y 21 ó más pulgadas. Los más habituales son los de 15 pulgadas, aunque cada vez son más los que apuestan por los de 17 pulgadas, que pronto pasarán a ser el estándar. Los de 14 pulgadas se usan cada vez menos. Todo esto se debe a que las tarjetas gráficas que se montan ahora soportan fácilmente resoluciones de hasta 1600×1280 pixel

Resolución

Un pixel es la unidad mínima de información gráfica que se puede mostrar en pantalla. Cuantos más pixeles pueda mostrar el monitor de más resolución dispondremos. Si trabajas con Windows la resolución ampliada es fundamental, puedes tener más iconos en pantalla, puedes tener abiertas varias aplicaciones y verlas a la vez, sin tener que maximizar cada una cuando cambies a ellas, etc.

La resolución está íntimamente relacionada con las dimensiones del monitor, pero no podemos guiarnos fiablemente por esto. Por ejemplo, hay algún monitor de 15 pulgadas que alcanza resoluciones de hasta 1600 x 1280, pero las dimensiones físicas de la pantalla hacen que todo se vea muy reducido, siendo un engorro y además pagamos por unas características que nunca utilizaremos. Para estas resoluciones ampliadas se recomienda: un monitor de 15 pulgadas para 1024 x 768, y uno de 17 o 20 pulgadas para 1280 x 1024 pixeles.

Frecuencia de barrido vertical

El rayo de electrones debe recorrer toda la superficie de la pantalla empezando por la esquina superior izquierda, y barriéndola de izquierda a derecha y de arriba abajo. La frecuencia de refresco, medida en Hertzios, es el número de veces que el cañón de electrones barre la pantalla por segundo. ¿Por qué es tan importante este valor? Pues porque si es una frecuencia baja, se hará visible el recorrido del haz de electrones, en forma de un molesto parpadeo de la pantalla. El mínimo debe ser de 70 Hz, pero un buen monitor debe ser capaz de alcanzar frecuencias superiores. Cuanto mayor sea el valor de este parámetro mejor, ya que permitirá mayores resoluciones sin necesidad de entrelazar. La imagen será más nítida y estable.

La alternativa LCD

Últimamente se habla del avance de la tecnología LCD o cristal líquido, llegando incluso a citarse como posible alternativa de futuro frente al tradicional CRT. Ventajas como el ahorro de consumo y de espacio (LCD posibilita la fabricación de pantalla extra-planas, de muy poca profundidad),

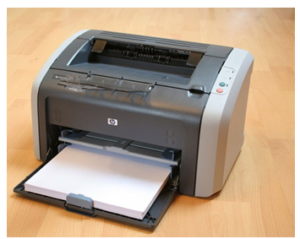

- Impresoras

Las impresoras es la que permite obtener en un soporte de papel una ¨hardcopy¨: copia visualizable, perdurable y transportable de la información de textos o gráficos en documentos almacenados en formato electrónico procesada por un computador. Las primeras impresoras nacieron muchos años antes que el PC e incluso antes que los monitores, siendo durante años el método más usual para presentar los resultados de los cálculos en aquellos primitivos ordenadores, todo un avance respecto a las tarjetas y cintas perforadas que se usaban hasta entonces. Muchas impresoras son usadas como periféricos, y están permanentemente unidas a la computadora por un cable. Otras impresoras, llamadas impresoras de red, tienen un interfaz de red interno (típicamente wireless o Ethernet), y que puede servir como un dispositivo para imprimir en papel algún documento para cualquier usuario de la red.

La velocidad de una impresora se suele medir con los parámetros:

- Ppm : páginas por minuto que es capaz de imprimir;

- Cps: caracteres (letras) por segundo que es capaz de imprimir

- Ppp: puntos por pulgada (cuadrada) que imprime una impresora.

Tipos de impresoras:

- De Impacto por matriz de aguja o punto.

Fueron las primeras que surgieron en el mercado. Se las denomina «de impacto» porque imprimen mediante el impacto de unas pequeñas piezas (la matriz de impresión) sobre una cinta impregnada en tinta y matriz de aguja porque su cabezal móvil de impresión contiene una matriz de agujas móviles en conductos del mismo, dispuestas en una columna (de 9 agujas por ejemplo) o más columnas. Para escribir cualquier cosa en color se tiene que sustituir la cinta de tinta negra por otro con tintas de los colores básicos (generalmente magenta, cyan y amarillo). Este método tiene el inconveniente de que el texto negro se fabricaba mezclando los tres colores básicos, lo que era más lento, más caro en tinta y deja un negro con un cierto matiz verdoso.

De Chorro o inyección de tinta

Se le denomina “inyección” porque la tinta suele ser impulsada hacia el papel por unos mecanismos que se denominan inyectores, mediante la aplicación de una carga eléctrica que hace saltar una minúscula gota de tinta por cada inyector. Esta destaca por la utilización del color, incorporan soporte para el uso simultáneo de los cartuchos de negro y de color.

La resolución de estas impresoras es en teoría bastante elevada, hasta de 1.440 Ppp, pero en realidad la colocación de los puntos de tinta sobre el papel resulta bastante deficiente, por lo que no es raro encontrar que el resultado de una impresora láser de 300 Ppp sea mucho mejor que el de una de tinta del doble de resolución. Por otra parte, suelen existir papeles especiales, mucho más caros que los clásicos folios de papelería, para alcanzar resultados óptimos a la máxima resolución o una gama de colores más viva y realista.

Este tipo de impresoras es utilizado generalmente por el usuario doméstico, además del oficinista que no necesita trabajar con papel continuo ni con reproducciones múltiples, pero sí ocasionalmente con color (logotipos, gráficos, pequeñas imágenes…) con una calidad aceptable.

- Láser

Son las de mayor calidad del mercado, si entendemos por calidad la resolución sobre papel normal que se puede obtener, unos 600 Ppp reales. En ellas la impresión se consigue mediante un láser que va dibujando la imagen electrostáticamente en un elemento llamado tambor que va girando hasta impregnarse de un polvo muy fino llamado tóner (como el de fotocopiadoras) que se le adhiere debido a la carga eléctrica. Por último, el tambor sigue girando y se encuentra con la hoja, en la cual imprime el tóner que formará la imagen definitiva.

Las impresoras láser son muy resistentes, mucho más rápidas y mucho más silenciosas que las impresoras matriciales o de tinta, y aunque la inversión inicial en una impresora láser es mayor que en alguna de las otras, el tóner sale más barato a la larga que los cartuchos de tinta, por lo que a la larga se recupera la inversión. Por todo ello, las del tipo láser son idóneas para entornos de oficina con una intensa actividad de impresión, donde son más importantes la velocidad, la calidad y el escaso coste de mantenimiento que el color o la inversión inicial.

Es importante considerar independientemente del tipo de impresora la calidad de los insumos como son, cartuchos, cintas, tóner, papel, ya que de ello depende en gran medida la vida útil de la impresora así como la calidad de impresión obtenida.

- Bocinas

otras son portátiles (audífonos). Existen modelos muy variados, de acuerdo a su diseño y la capacidad en watts que poseen.

DATA SHOW O CAÑONES:

Es una unidad de salida de información. Es básicamente una pantalla plana de cristal líquido, transparente e independiente. Acoplado a un retroproyector permite la proyección amplificada de la información existente en la pantalla del operador.

Existe una variante tecnológica del data show, conocida como el cañón de proyección, que puede ser catalogada como un sistema independiente de proyección mediante lentes, muy similar a un proyector de video. Los modelos más recientes de cañones utilizan LCDs.

- Dispositivos de almacenamiento

Los sistemas informáticos pueden almacenar los datos tanto interna (en la memoria) como externamente (en los dispositivos de almacenamiento). Internamente, las instrucciones o datos pueden almacenarse por un tiempo en los chips de silicio de la RAM (memoria de acceso aleatorio) montados directamente en la placa de circuitos principal de la computadora, o bien en chips montados en tarjetas periféricas conectadas a la placa de circuitos principal del ordenador.

En el caso de los dispositivos de almacenamiento externos, que pueden residir físicamente dentro de la unidad de proceso principal del ordenador, están fuera de la placa de circuitos principal. Estos dispositivos almacenan los datos en forma de cargas sobre un medio magnéticamente sensible, por ejemplo una cinta de sonido o, lo que es más común, sobre un disco revestido de una fina capa de partículas metálicas. Los dispositivos de almacenamiento externo más frecuentes son los disquetes y los discos duros, aunque la mayoría de los grandes sistemas informáticos utiliza bancos de unidades de almacenamiento en cinta magnética.

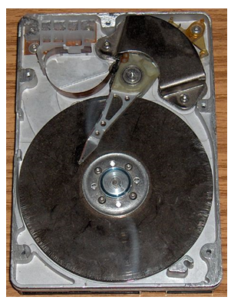

- Disco Duro

Este está compuesto por varios platos, es decir, varios discos de material magnético montados sobre un eje central sobre el que se mueven. Para leer y escribir datos en estos platos se usan las cabezas de lectura / escritura que mediante un proceso electromagnético codifican / decodifican la información que han de leer o escribir. La cabeza de lectura / escritura en un disco duro está muy cerca de la superficie, de forma que casi da vuelta sobre ella, sobre el colchón de aire formado por su propio movimiento. Debido a esto, están cerrados herméticamente, porque cualquier partícula de polvo puede dañarlos.

Este se divide en unos círculos concéntricos cilíndricos (coincidentes con las pistas de los disquetes), que empiezan en la parte exterior del disco (primer cilindro) y terminan en la parte interior (ultimo). Asimismo, estos cilindros se dividen en sectores, cuyo número está determinado por el tipo de disco y su formato, siendo todos ellos de un tamaño fijo en cualquier disco. Cilindros como sectores se identifican con una serie de números que se les asigna, empezando por el 1, pues el numero 0 de cada cilindro se reservan para propósitos de identificación más que para almacenamientos de datos. Estos escritos / leídos en el disco deben ajustarse al tamaño fijado del almacenamiento de los sectores. Habitualmente, los sistemas de discos duros contienen más de una unidad en su interior, por lo que el número de caras puede ser más de dos. Estas se identifican con un número, siendo el 0 para la primera. En general su organización es igual a los disquetes. La capacidad del disco resulta de multiplicar el número de caras por el de pistas por cara y por el de sectores por pista, al total por el número de bytes por sector.

Los discos giran continuamente a gran velocidad; este detalle, la velocidad de rotación, incide directamente en el rendimiento de la unidad, concretamente en el tiempo de acceso. Es el parámetro más usado para medir la velocidad de un disco duro, y lo forma la suma de dos factores:

El tiempo medio de búsqueda y la latencia; el primero es lo que tarde el cabezal en desplazarse a una pista determinada, y el segundo es el tiempo que emplean los datos en pasar por el cabezal.

Si se aumenta la velocidad de rotación, la latencia se reduce; en antiguas unidades era de 3.600 rpm (revoluciones por minuto), lo que daba una latencia de 8,3 milisegundos. La mayoría de los discos duros actuales giran ya a 7.200 rpm, con lo que se obtienen 4,17 mb de latencia. Y actualmente, existen discos de alta gama aún más rápidos, hasta 10.000 rpm.

Los discos duros no pueden extraerse de los receptáculos de la unidad de disco, que contienen los dispositivos electrónicos para leer y escribir datos sobre la superficie magnética de los discos y pueden almacenar desde varios millones de bytes hasta algunos centenares de millones. La tecnología de CD-ROM, que emplea las mismas técnicas láser utilizadas para crear los discos compactos (CD) de audio, permiten capacidades de almacenamiento del orden de varios cientos de megabytes (millones de bytes) de datos.

- Almacenamiento óptico

De Wikipedia, la enciclopedia libre

Saltar a navegación, búsqueda

Variante de almacenamiento informático surgida a finales del siglo XX consistente en la lectura a través de haces de luz que interpretan las refracciones provocadas sobre su propia emisión. Los soportes de almacenamiento más famosos que hacen uso de este tipo de almacenamiento son el CD-ROM y el DVD. Existen otros en desarrollo como el EVD. el Blu-Ray o el HD-DVD.

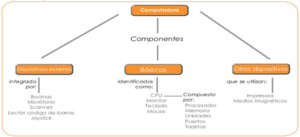

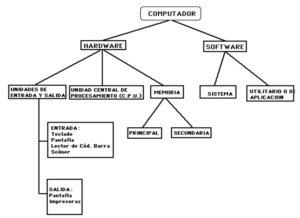

Mapa conceptual

UN COMPUTADOR ES EL RESULTADO DE LA SUMA DE DOS COMPONENTES: HARDWARE Y SOFTWARE.

ESQUEMA DE COMPOSICIÓN DE UNA COMPUTADORA

Hardware

Hardware es un neologismo proveniente del inglés definido por la RAE como el conjunto de elementos materiales que conforman una computadora, sin embargo, es usual que sea utilizado en una forma más amplia, generalmente para describir componentes físicos de una tecnología, así el hardware puede ser de un equipo , un equipo electrónico, un equipo informático o un robot. En informática también se aplica a los periféricos de una computadora tales como el disco duro, CD-ROM, disquette (floppy), etc… En dicho conjunto se incluyen los dispositivos electrónicos y electromecánicos, circuitos, cables, armarios o cajas, periféricos de todo tipo y cualquier otro elemento físico involucrado.

El hardware se refiere a todos los componentes físicos (que se pueden tocar), en el caso de una computadora personal serían los discos, unidades de disco, monitor, teclado, la placa base, el microprocesador, étc. En cambio, el software es intangible, existe como información, ideas, conceptos, símbolos, pero no ocupa un espacio físico, se podría decir que no tiene sustancia. Una buena metáfora sería un libro: las páginas y la tinta son el hardware, mientras que las palabras, oraciones, párrafos y el significado del texto (información) son el software. Una computadora sin software sería tan inútil como un libro con páginas en blanco.

Microcontrolador Motorola 68HC11 y chips de soporte que podrían constituir el hardware de un equipo electrónico industrial

Tipos de hardware

Se clasifica generalmente en básico y complementario, entendiendo por básico todo aquel dispositivo necesario para iniciar el funcionamiento de la computadora, y el complementario, como su nombre indica, sirve para realizar funciones específicas (más allá de las básicas) no estrictamente necesarias para el funcionamiento de la computadora.

Todo sistema informático tiene componentes, hardware dedicados a alguna de estas funciones:

- Periféricos de entrada

- Periféricos de salida

- Periféricos de entrada/salida

- Memoria

- Unidad central de procesamiento

Cada dispositivo de entrada es solo otra fuente de señales eléctricas; cada dispositivo de salida no es más que otro lugar al cual enviar señales (salidas); los dispositivos de almacenamiento y las memorias son ambas cosas, dependiendo de lo que requiera el programa (operación de entrada=lectura, operación de salida=escritura).

Software

Programas en la pantalla de una computadora

Se denomina software (palabra de origen anglosajón, pronunciada «sóft-uer»), programa, equipamiento lógico o soporte lógico a todos los componentes intangibles de una computadora, es decir, al conjunto de programas y procedimientos necesarios para hacer posible la realización de una tarea específica, en contraposición a los componentes físicos del sistema (hardware). Esto incluye aplicaciones informáticas tales como un procesador de textos, que permite al usuario realizar una tarea, y software de sistema como un sistema operativo, que permite al resto de programas funcionar adecuadamente, facilitando la interacción con los componentes físicos y el resto de aplicaciones.

Probablemente la definición más formal de software es la atribuida a la IEEE en su estándar 729: «la suma total de los programas de cómputo, procedimientos, reglas documentación y datos asociados que forman parte de las operaciones de un sistema de cómputo» [1] . Bajo esta definición, el concepto de software va más allá de los programas de cómputo en sus distintas formas: código fuente, binario o ejecutable, además de su documentación: es decir, todo lo intangible.

El término «software» fue usado por primera vez en este sentido por John W. Tukey en 1957. En las ciencias de la computación y la ingeniería de software, el software es toda la información procesada por los sistemas informáticos: programas y datos. El concepto de leer diferentes secuencias de instrucciones de la memoria de un dispositivo para controlar cálculos fue inventado por Charles Babbage como parte de su máquina diferencial. La teoría que forma la base de la mayor parte del software moderno fue propuesta por vez primera por Alan Turing en su ensayo de 1936, Los números computables, con una aplicación al problema de decisión.

Si bien esta distinción es, en cierto modo, arbitraria, y, a veces, difusa y confusa, se puede distinguir al software de la siguiente forma:

Software de Sistema , es la parte que permite funcionar al hardware. Su objetivo es aislar tanto como sea posible al programador de aplicaciones de los detalles del computador particular que se use, especialmente de las características físicas de la memoria, dispositivos de comunicaciones, impresoras, pantallas, teclados, etcétera. Incluye entre otros:

- Sistemas operativos

- Controladores de dispositivo

- Herramientas de diagnóstico

- Servidores

- Sistemas de ventanas

- Utilidades

- Software de Programación, que proporciona herramientas para ayudar al programador a escribir programas informáticos y a usar diferentes lenguajes de programación de forma práctica. Incluye entre otros:

- Editores de texto

- Compiladores

- Intérpretes

- Enlazadores

- Depuradores

- Los entorno de desarrollo integrados (IDE) agrupan estas herramientas de forma que el programador no necesite introducir múltiples comandos para compilar, interpretar, depurar, etcétera, gracias a que habitualmente cuentan con una interfaz gráfica de usuario (GUI) avanzada.

- Software de aplicación, que permite a los usuarios llevar a cabo una o varias tareas más específicas, en cualquier campo de actividad susceptible de ser automatizado o asistido, con especial énfasis en los negocios. Incluye entre otros:

Formas

El software adopta varias formas en distintos momentos de su ciclo de vida:

- Código fuente: escrito por programadores. Contiene el conjunto de instrucciones destinadas a la computadora.

- Código objeto: resultado del uso de un compilador sobre el código fuente. Consiste en una traducción de éste último. El código objeto no es directamente inteligible por el ser humano, pero tampoco es directamente entendible por la computadora. Se trata de una representación intermedia del código fuente. Véase MSIL (Microsoft Intermediate Languaje)

- Código ejecutable: resultado de enlazar uno o varios fragmentos de código objeto. Constituye un archivo binario con un formato tal que el sistema operativo es capaz de cargarlo en la memoria de una computadora, y proceder a su ejecución. El código ejecutable es directamente inteligible por la computadora.

El proceso de creación de software

El proceso de creación de software es materia de la ingeniería del software, una de las ramas propias de la Ingeniería Informática. Es un proceso complejo que involucra diversas tareas de gestión y desarrollo. Como resumen de las etapas para la creación de un software, se pueden mencionar:

- Análisis

- Desarrollo

- Construcción

- Pruebas (unitarias e integradas)

- Paso a Producción

Dentro de estas etapas, existen sub-etapas (para algunos son otras etapas, como por ejemplo, paso a ambiente beta/rc).

Vistas

TIPOS DE SOFTWARE

En la actualidad hay diferentes categorías de aplicaciones para la computadora, si nos atenemos a su licencia; muchas de ellas pueden prestarse a confusión, por eso trataremos de aclarar lo que significan los diferentes calificativos aplicados al software.

- Software comercial

Es el desarrollado por una empresa con intención de venderlo y obtener unos beneficios. No debe confundirse con propietario, puesto que hay software libre que es comercial, aunque es cierto que la mayoría del software comercial es propietario. - Software libre

Es aquel que puede ser distribuido, modificado, copiado y usado; por lo tanto, debe venir acompañado del código fuente para hacer efectivas las libertades que lo caracterizan. Dentro de software libre hay, a su vez, matices que es necesario tener en cuenta. Por ejemplo, el software de dominio público significa que no está protegido por el copyright, por lo tanto, podrían generarse versiones no libres del mismo, en cambio el software libre protegido con copyleft impide a los redistribuidores incluir algún tipo de restricción a las libertades propias del software así concebido, es decir, garantiza que las modificaciones seguirán siendo software libre. También es conveniente no confundir el software libre con el software gratuito, éste no cuesta nada, hecho que no lo convierte en software libre, porque no es una cuestión de precio, sino de libertad. - Software semilibre

Es aquel que mantiene las mismas características que el software libre para los usuarios individuales, entidades educativas o sin ánimo de lucro, sin embargo prohibe esas libertades para su uso comercial o empresarial. - Software propietario

Es aquel que no es libre ni semilibre, por lo tanto, su redistribución, modificación y copia están prohibidas o, al menos, tan restringidas que es imposible hacerlas efectivas.

Freeware

No tiene una definición clara y precisa, sin embargo suele usarse para clasificar al software que puede redistribuirse libremente pero no modificarse, entre otras cosas, porque no está disponible su código fuente. El freeware no es software libre. Shareware

Es un software que permite su redistribución, sin embargo no viene acompañado de su código fuente y, por tanto, no puede ser modificado. Además, pasado un periodo de tiempo, normalmente es necesario pagar una licencia para continuar usándolo, luego tampoco es software libre. software de Aplicación

Las computadoras y el software de aplicación han permitido al hombre, simplificar y mejorar muchas tareas rutinarias y repetitivas. Por ello, este software o programas le han dado a las computadoras un carácter muy práctico y popular. Estos programas son empleados por el usuario para simplificar su vida, ya sea si decide escribir un libro, una tesis o un memorándum, o para poder manejar grandes volúmenes de datos; o aquellos programas que le sirvan para emitir una nómina de una empresa. Estos programas son los más solicitados por la mayoría de usuarios de computadoras debido a los beneficios o servicios que reciben de ellos. Existen también programas de aplicación que brindan al usuario otro tipo de servicios; por ejemplo, los juegos por computadora son muy estimados, ya que gracias a ellos el usuario obtiene diversión y esparcimiento. Los programas orientados a la edición de texto por computadora permiten al usuario obtener combinación de texto con imágenes de alta calidad profesional y gráficos. Los hay también educativos, matemáticos, estadísticos, etc. El software de aplicación más difundido en el mercado se puede dividir en varias categorías, las principales son:

|

Software de Comunicación

Para lograr que dos o más computadoras se comuniquen entre sí, es necesario que exista tanto un medio físico como uno lógico que permita a ambas entablar comunicación. El software de comunicación se refiere al conjunto de programas que cumple la función lógica descrita anteriormente.

Actualmente existe en el mercado de las comunicaciones de datos una amplia variedad de software de comunicación, entre los que se encuentran:

- Smartcomm (Ambiente Windows).

- Quick Link II.

- Procomm Plus (Ambiente DOS).

- SLIP (Serial on Line Internet Protocol).

- PPT (Pert to Pert Protocol).

- Camaleon.

- Winsockets.

Los tres primeros productos no permiten copiar información mediante el programa FTP (File Transfer Protocol o protocolo de Transferencia de Archivos), mientras que el resto si lo permite.

El software de SLIP, desarrollado por la Universidad de Minnesota de los EUA permite tener acceso a todos los servicios de la red Internet desde cualquier computadora personal utilizando un módem y una línea telefónica.

Mainframe

Computadoras grandes, potentes y costosas capaces de procesar cantidad de información para diferentes usuarios al mismo tiempo. Son utilizadas en organizaciones donde se requiere que muchos usuarios tengan acceso a la misma información, así cada persona tiene una terminal y un monitor, pero no tiene un CPU (unidad central de proceso), ya que todas están conectadas a el mainframe y su costo es muy alto.

Los Mainframes se definen tanto por la velocidad de su CPU como por su gran memoria interna, su alta y gran capacidad de almacenamiento externo, sus resultados en los dispositivos E/S rápidos y considerables, la alta calidad de su ingeniería interna que tiene como consecuencia una alta fiabilidad y soporte técnico caro pero de alta calidad.

Un Mainframe puede funcionar durante años sin problemas ni interrupciones y las reparaciones del mismo pueden ser realizadas mientras está funcionando. Los vendedores de mainframes ofrecen servicios especiales; por ejemplo, si se rompe la computadora, el vendedor ejecutará las aplicaciones de su cliente en sus propias computadoras sin que los usuarios lo noten mientras que duran las reparaciones.

A menudo, los mainframes soportan miles de usuarios de manera simultánea que se conectan mediante falsos terminales. Algunos mainframes pueden ejecutar o dar cobijo a muchos sistemas operativos y por lo tanto, no funcionan como una computadora sola, sino como varias computadoras virtuales.

Un mainframe por sí solo puede remplazar docenas o cientos de pequeñas computadoras personales, reduciendo los costos administrativos y de gestión al tiempo que ofrece una escalabilidad y fiabilidad mucho mejor. La fiabilidad se consigue por la independencia de sus componentes internos, y la escalabilidad se logra porque los recursos físicos de la computadora pueden ser redistribuidos entre los terminales virtuales según las necesidades; esto es mucho más difícil de hacer con las computadoras personales, porque para quitar o añadir nuevos componentes físicos hay que desenchufar la computadora muchas veces y las limitaciones de dichos componentes son mucho mayores.

Minicomputadora

En 1960 surgió la Minicomputadora, una versión más pequeña de la Macrocomputadora. Al ser orientada a tareas específicas, no necesitaba de todos los periféricos que necesita un Mainframes, y esto ayudó a reducir el precio y costo de mantenimiento. Las Minicomputadora, en tamaño y poder de procesamiento, se encuentran entre los Mainframes y las estaciones de trabajos, pero en menor escala, actualmente son conocidos como servidores.

Microcomputadora

Una microcomputadora es una computadora que tiene un microprocesador (unidad central de procesamiento). Generalmente, el microprocesador tiene los circuitos de almacenamiento (o memoria caché) y entrada/salida en el mismo circuito integrado (o chip). El primer microprocesador comercial fue el Intel 4004, que salió el 15 de noviembre de 1971.

Dentro de esta categoría se encuentran tanto las computadoras portátiles como las computadoras de escritorio, en estas solo disminuyo si tamaño y aumento su velocidad de procesamiento, si no que también se redujo su precio, y esto permite que cada día estén al alcance de más personas, tan es así que las podemos encontrar en las organizaciones instituciones educativas, hogares, etcétera.

El aumento de velocidad de procesamiento también provoco que las compañías desarrolladoras de software mejoren las aplicaciones existentes para hacerlas más eficientes y diseñen nuevas también, con esto se logró que en la actualidad existan gran variedad de aplicaciones.

El término computadora personal se aplica a las microcomputadoras orientadas a los consumidores. La primera generación de microcomputadora fue conocida también como computadoras domésticas, y con la evolución de programas de cálculo provoco que las microcomputadoras dejaran de ser un pasatiempo para los aficionados y convertirse en una herramienta de trabajo.

Sus principales características son:

- Velocidad de procesamiento: Decenas de millones de instrucciones por segundo.

- Tamaño: Pequeña, o portátiles.

- Facilidad de uso.

- Clientes usuales: Pequeñas empresas, oficinas, escuelas, individuos.

- Penetración social.

- Impacto social: Alto.

- Costo: Pocos miles de dólares estadounidenses.

Supercomputadora

Supercomputadora o Superordenador son computadoras muy potentes, construidas para procesar cantidad de datos y utilizadas para resolver problemas que requieren cálculos complejos. Principalmente usadas en el ámbito gubernamental y científico.

Por su alto costo, el uso de superordenadores verdaderos está limitado a organismos gubernamentales, militares y grandes centros de investigación, en donde tienen aplicaciones científicas, como en la simulación de procesos naturales (previsión del tiempo, análisis de cambios climáticos, entre otros procesos.

Una supercomputadora es un tipo de computadora muy potente y rápida, diseñada para procesar enormes cantidades de información en poco tiempo y dedicada a una tarea específica.

Por lo mismo son las más caras, su precio alcanza los 20 millones de euros o más (30 millones de dólares); y cuentan con un control de temperatura especial, esto para disipar el calor que algunos componentes alcanzan a tener.

Sus principales características son:

- Velocidad de Proceso: Miles de millones de instrucciones de coma flotante por segundo.

- Usuarios a la vez: Hasta miles, en entorno de redes amplias.

- Tamaño: Requieren instalaciones especiales y aire acondicionado industrial.

- Facilidad de uso: Solo para especialistas.

- Clientes usuales: Grandes centros de investigación.

- Penetración social Baja.

- Impacto social: Casi nulo, pero sin los supercomputadores no se podrían hacer cosas como la predicción del tiempo a una década de distancia o resolver cálculos muy complejos que no se pueden resolver a mano.

- Parque instalado: Menos de un millar en todo el mundo.

Computadora Portátil

Una computadora portátil también llamado en inglés laptop o notebook, es una pequeña computadora personal móvil, que pesa normalmente entre 1 y 3 Kg. Los computadores portátiles son capaces de realizar la mayor parte de las tareas que realizan las computadoras de escritorio, con la ventaja de ser más pequeños, livianos y de tener la capacidad de operar desconectados por un período determinado.

Componentes

Muchos de los componentes de una computadora portátil son similares a los componentes de las computadoras de escritorio, pero habitualmente son de menor tamaño; con componentes similares por citar algunos:

- CPU de bajo consumo: Intel Pentium M o AMD Turion 64.

- Disco duro de 2,5 pulgadas o menor, frente a los discos de 3,5 pulgadas de los ordenadores de sobremesa.

- Módulos de memoria RAM SO DIMM (Small Outline DIMM) más pequeños que los DIMM usuales en los ordenadores de sobremesa, otros son DDR2.

- Unidad lectora y grabadora de CD o DVD de formato reducido.

- Teclado integrado.

- Pantalla integrada tipo TFT, que a su vez realiza la función de tapa del portátil facilitando su transporte.

- Panel táctil para manejar el puntero en lugar del mouse (ratón).

- Cargador (se pueden cargar en uso para optimizar tiempo y energía).

Estación de trabajo

Las estaciones de trabajos se encuentran entre las Minicomputadoras y las Macrocomputadoras (por el procesamiento). Son un tipo de computadoras que se utilizan para aplicaciones que requieran de poder de procesamiento moderado y capacidades de gráficos de alta calidad. Son usadas para: Aplicaciones de ingeniería, CAD (Diseño Asistido por Computadora), CAM (Manufactura Asistida por Computadora), publicidad, creación de Software

En una red de computadoras, una estación de trabajo es una computadora que facilita a los usuarios el acceso a los servidores y periféricos de la red.

Las Estaciones de Trabajo usualmente consisten de una pantalla de alta resolución, un teclado y un ratón como mínimo. Las estaciones de trabajo, en general, han sido los primeros en ofrecer accesorios avanzados y herramientas de colaboración tales como la videoconferencia.